Cara Setting Robots.txt di Blogger SEO yang Benar, agar halaman dan postingan website atau blog lebih cepat dan otomatis terindeks di google.

Apa itu Robot.txt ?

Robots.txt adalah file yang berguna memberi tahu crawler mesin telusur URL mana yang dapat diakses di situs Anda.

File ini digunakan terutama agar situs Anda terhindar dari beban permintaan yang terlampau banyak; file ini bukanlah mekanisme untuk menyembunyikan halaman web dari Google.

Untuk menyembunyikan halaman dari Google, blokir pengindeksan dengan noindex atau lindungi halaman dengan sandi.

Untuk apa file robots.txt digunakan?

File robots.txt digunakan terutama untuk mengelola traffic crawler ke situs Anda, dan biasanya menyembunyikan halaman dari Google.

Cara Setting Robots.txt di Blogger SEO yang Benar

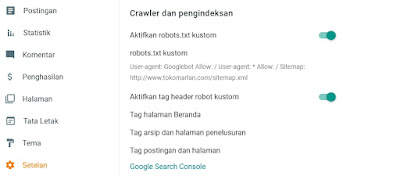

Berikut ini cara setting Robot.txt di blogger :

1. Buka Blogger.com

2. Masuk Setelan

3. Aktifkan Robot.txt

4. Masuk text berikut di kolom robot.txt kustom

User-agent: Googlebot

Disallow: /search

User-agent: *

Allow: /

Sitemap: http://www.bloganda.com/sitemap.xml

Berikut maksud dari file robots.txt tersebut:

- Agen pengguna yang bernama Googlebot tidak diizinkan meng-crawl URL apa pun yang diawali dengan http://example.com/search dikarenakan google tidak mengijinkan hasil pencarian blog terindeks.

- Semua agen pengguna lainnya diizinkan untuk meng-crawl seluruh situs. Hal ini dapat dihilangkan dan hasilnya akan sama, karena perilaku default-nya adalah agen pengguna diizinkan meng-crawl seluruh situs.

- File peta situs pada situs terletak di http://www.example.com/sitemap.xml.